Flexibles Referenzmodell zur Planung und Optimierung der Produktion - Generierung digitaler Fabrikmodelle mit dem digitalen Zwilling

Der digitale Zwilling dringt immer weiter in den Fokus von Produktionsunternehmen vor und wurde von Gartner als wichtige Schlüsseltechnologie identifiziert [1]. Volkswagen setzt die Technologie in der Cloud ein, um zukünftig die Produktion an allen Standorten digital zu planen, zu steuern und zu optimieren [2]. Dennoch ist diese Technologie im Mittelstand bisher kaum vertreten. Dieser Beitrag beschreibt ein flexibles Referenzmodell für die Planung und Optimierung der Produktion durch den digitalen Zwilling. Der Fokus liegt zum einen auf der Optimierung statischer Layouts und Materialflüsse und zum anderen auf der Optimierung der dynamischen Materialflüsse und der zeitlichen Organisation von Prozessen.

Kürzere Produktlebenszyklen und gesteigerte Variantenvielfalt erzeugen eine erhöhte Varianz und Komplexität in der Produktion. Die Planung von Produktionssystemen mit klassischen, oftmals analogen Werkzeugen, stößt daher zunehmend an ihre Grenzen. Neue Chancen bieten digitale Planungstools, allen voran die Simulation und der digitale Zwilling. Dieser ermöglicht die Erzeugung und Simulation digitaler Modelle in near-real-time und unterstützt die Analyse und Verbesserung komplexer Produktionssysteme.

Der digitale Zwilling ist in diesem Beitrag ein Oberbegriff für ein Set von Methoden und Modellen, welche die reale Produktion und deren Abläufe digital abbilden. Gemäß Kritzinger verfügt er über eine bidirektionale Datenverbindung zum realen System [3]. Er erhält Daten aus der realen Produktion durch die betrieblichen Informationssysteme. Analyse und Optimierung erfolgen durch die Simulation. Abgeleitete Verbesserungen werden über die betrieblichen Informationssysteme in die reale Produktion zurückgeführt. Der Fokus in diesem Beitrag liegt auf Job-Shop-Produktionssystemen und deren ganzheitlicher Abbildung im virtuellen Raum.

Für die Konzeption eines Referenzmodells definiert dieser Beitrag drei Forschungsfragen. Im zweiten Teil werden die gegenwärtigen Herausforderungen bei der Entwicklung digitaler Modelle diskutiert. Es folgt ein Konzept zur Realisierung des Referenzmodells. Ein Fallbeispiel dient zur Validierung des Konzepts und als Grundlage für die Einordnung und Diskussion. Im Ausblick folgen ungelöste Herausforderungen und die nächsten Schritte.

Forschungsfrage

Bild 1: Herausforderungen des digitalen Referenzmodells.

Insbesondere bei KMUs ist die Durchdringung von digitalen Planungstools gering, Simulationswerkzeuge sind kaum existent. Um diese Herausforderungen anzugehen arbeiten die Hochschule Offenburg, das Institut der Angewandten Wissenschaften Straßburg sowie die Universität Straßburg im Rahmen des Forschungsprojekts VIRTFac gemeinsam an einem flexiblen Referenzmodell. Schwerpunkte sind die Erfassung von Produktionsdaten, die Modellgenerierung und Simulation sowie die Optimierung, vgl. Bild 1. Die Generierung digitaler Modelle beginnt bei der Erfassung von Produktionsdaten aus den Quellsystemen. Das zu entwickelnde Referenzmodell dient als Grundlage für die Strukturierung von Produktionsdaten in der Datenbank. Die automatisierte Modellgenerierung und Simulation erlauben die Analyse und Optimierung realer Systeme. Aus diesem Prozess ergeben sich drei Forschungsfragen:

- Erfassung und Übergabe von Daten: Wie können Produktionsdaten systematisch erfasst und für die Simulation bereitgestellt werden?

- Modellierung und Simulation: Wie sieht die ideale Struktur eines Referenzmodells für die Modellierung und Simulation von Layout und Materialflüssen aus?

- Analyse und Optimierung: Wie kann Simulation zur Analyse und Verbesserung realer Produktions- und Logistiksystemen eingesetzt werden?

Für den industriellen Einsatz ist zunächst die Implementierung des Referenzmodells in einem Demonstrator vorgesehen. Im Fokus der Implementierung steht die Verwendung von Open-Source-Tools. Zusätzlich sollen weitere Planungstools flexibel implementiert werden können.

Stand der Technik

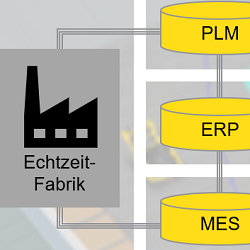

Eine 2012 durchgeführte Grundlagenstudie zur Erfassung von Simulationsdaten ergab, dass 40 - 50 % der Gesamtzeit von Simulationsstudien für die Datenerfassung aufgewendet wird [4]. Die Problematik wird durch jüngere Studien bestätigt [3, 5]. Der Anteil händischer Prozesse liegt dabei bei 80 %. Die Ursache sind heterogene IT-Landschaften. Das Ergebnis sind Probleme mit der Datenqualität wie Lücken, Duplikate und Inkonsistenz. Eine weitere Studie untersuchte die Quellsysteme des digitalen Zwillings und identifizierte unter anderem PLM, MES, und ERP [5]. Weitere, unstrukturierte Datenquellen und Office-Lösungen sind keine Seltenheit bzw. an der Tagesordnung.

Für die Datenübergabe in die Simulationswerkzeuge klassifiziert die Literatur bestehende Ansätze in vier Kategorien [6]. Mit steigendem Automatisierungsgrad sind das die händische Datenpflege, die Übergabe mittels Datentabellen, die Übergabe mittels Datenbanken sowie der direkte Austausch mit den betrieblichen Informationssystemen. Die beiden erstgenannten Methoden sind aufgrund von Aufwand und Zeitverzug bei der manuellen Übergabe der Daten für die unmittelbare Modellgenerierung und Simulation sehr ungeeignet. Der Fokus liegt daher auf dem Datentransfer mittels Datenbank und dem direkten Austausch mit den Quellsystemen.

Herausforderung bei der Modellierung und Simulation ist das Verständnis über die erfassten Daten. Erst durch die Verknüpfung von Daten aus verschiedenen Quellsystemen entsteht ein Kontext und aus den isolierten Daten entsteht ein digitales Modell. Die Literatur bietet eine Vielzahl verschiedener Standards und Datenmodelle [5]. Zu nennen sind CMSD, PPR, AutomationML, ISA95, SysML. Der Bedarf nach domänenspezifischen, fallneutralen Datenmodellen für individuelle Anwendungsfälle bleibt dennoch bestehen [3, 5].

Die Implementierung des Datenmodells in einer Datenbank erzeugt ein digitales Modell. Dieses besteht typischerweise aus mehreren Datentabellen, die jeweils mehrere Tausend Zeilen Inhalt enthalten können. Für Analyse und Interpretation sind diese ungeeignet. Die Literatur bietet eine hohe Anzahl von Ansätzen zur Überführung abstrakter Datenmodelle in digitale Modelle [7]. Diese adressieren individuelle Probleme. Ein allgemeiner Standard hat sich bisher kaum durchgesetzt [3].

Die Analyse und Optimierung findet in digitalen Planungstools statt. Diese können beispielsweise eine statische Layout- und Materialflussanalyse sowie eine dynamische Ablaufsimulation sein. Um reale Systeme durch digitale Modelle verbessern zu können, ist ein fundiertes Expertenwissen erforderlich, das im Bereich der KMU oft nicht vorhanden ist. Ein systematisches Vorgehen für Modellierung und Simulation von statischen Layouts und dynamischen Materialflüssen wurde bisher nicht identifiziert.

Weiter entstehen in der Simulation große Mengen von Daten. Zur Analyse großer Datenmengen sind Simulationswerkzeuge kaum geeignet. In anderen Disziplinen haben sich unter dem Begriff Big Data Technologien zur Auswertung und Analyse großer Datenmengen durchgesetzt. Dies bedingt die Bereitstellung von Simulationsergebnissen außerhalb der Planungstools. Trotz großer Wichtigkeit der Auswertung und Interpretation der Ergebnisse erkennt die Literatur eine Forschungslücke bei der systematischen Datenanalyse [6].

Referenzmodell

Bild 2: Referenzmodell für digitale Planung und Optimierung.

Um die genannten Herausforderungen anzugehen, konzipierte die Hochschule Offenburg gemeinsam mit ihren Forschungspartnern ein flexibles Referenzmodell zur Integration des digitalen Zwillings in die Planung und Optimierung. Bild 2 zeigt das entworfene Referenzmodell. Die Implementierung des Referenzmodells in einem Demonstrator ist die Grundlage für den praktischen Einsatz des Referenzmodells in der Planung und Optimierung von Produktionssystemen im Bereich von KMUs. Das Konzept sieht die Erfassung von Produktionsdaten aus definierten Quellsystemen vor. Namentlich sind dies ERP mit der Auftrags-, Ressourcen- und Kapazitätsplanung, PLM mit der Sicht des Engineerings sowie MES mit der Feinplanung und den operativen Vorgängen der Produktion. MES dient als Schnittstelle zur physischen Fertigung. Die Vereinigungsmenge dieser Daten beschreibt alle relevanten Sichten auf die Produktion und ist Grundlage für die Analyse und Verbesserung realer Produktionssysteme durch die Simulation in digitalen Modellen.

Die Verdichtung der Daten aus den Quellsystemen erfolgt in einer Datenbank, die das Rückgrat dieses Ansatzes darstellt. Die Implementierung der Datenbank erfolgt in einem, an das Produkt-, Prozess- und Ressourcenmodell angelehnten Datenmodell [8]. Die Modellierung weiterer Systemelemente basiert auf den Daten der betrieblichen Informationssysteme. Datenbankabfragen übertragen Informationen aus den Quellsystemen in die Datenbank. Das Datenmodell strukturiert die Daten der realen Fabrik in fallspezifischen Datensets und stellt diese dann für die Simulation bereit.

Für die Simulation überführt die Methodik das generische Datenmodell in spezifische Datenmodelle der vorgesehenen Planungstools und führt Modellgenerierung und Simulation aus. Der Output sind Ergebnisse für die Analyse und Verbesserung der realen Systeme. Hierfür ist dann die Übertragung von Experimenten und Simulationsergebnissen zurück in die generische Datenbank erforderlich.

Das Datenmodell beschreibt die Produktion neutral. So können einzelne Quellsysteme durch spezifische Programme anderer Hersteller ausgetauscht werden. Ebenso können simulationsseitig die Fabrikplanungstools durch Werkzeuge mit anderen Funktionen oder von anderen Herstellern ersetzt werden. Selbiges gilt für die Tools der Data-Science zur Analyse und Visualisierung von Simulationsergebnissen. Das digitale Modell der Datenbank ist somit die Datendrehscheibe des digitalen Zwillings, Schnittstelle zu den definierten Quell- und Zielsystemen sowie die Grundlage für die Flexibilität des Referenzmodells.

Demonstrator

Bild 3: Modellgenerierung in den Planungstools.

Die Umsetzung des Demonstrators erfolgt mit einer SQLite-Datenbank. Die Strukturierung der Daten erfolgt auf Basis des entworfenen Datenmodells. Als Quellsysteme für den Demonstrator wurden im Mittelstand gängige Informationssysteme ERP, PLM und MES ausgewählt. Auf Seite der Fabrikplanungstools wird die statische Layout- und Materialflussanalyse mit Plavis visTABLE und die dynamische Prozesssimulation mit Siemens Plant Simulation realisiert.

Für die Umsetzung des Datenmanagements wurde das BI-Tool KNIME gewählt. Das BI-Tool unterstützt den Gedanken einer zentralen Datendrehscheibe durch seine inhärente Konnektivität. Durch eine Vielzahl standardisierter Konnektoren können die Quell- und Ziel-Systeme mit der Datenbank verbunden und Systeme beliebig substituiert werden. Die Konnektoren bedienen die Schnittstelle von technischer Seite. Das Referenzmodell schafft die sachlogische Verknüpfung der Daten.

Bild 3 zeigt schematisch den Prozess der Erstellung simulationsfähiger Modelle. Aus dem ERP-System werden das Ressourcenmodell, die Arbeitspläne sowie das Produkt- und Mengengerüst in die Datenbank übernommen. Das Datenmodell strukturiert die Daten sachlogisch für die Bereitstellung in den Planungstools. Die automatisierte Modellgenerierung erzeugt aus dem abstrakten Modell der Datenbank experimentierbare Simulationsmodelle.

In Bild 3 rechts abgebildet sind die Modelle in der statischen Layout- und Materialflussanalyse und der dynamischen Ablaufsimulation. Erstgenanntes ist geeignet um Fragen der Layoutgestaltung wie beispielsweise der Minimierung von Transportaufwand und -distanz zu beantworten. Zweitgenanntes adressiert Fragen des dynamischen Materialflusses und des zeitlichen Ablaufs von Prozessen. Die Aufnahme der Simulationsergebnisse in das Referenzmodell bildet die Grundlage für weitere Optimierungsmöglichkeiten mit Hilfe von Data Science und KI-Tools.

Ausblick

Mit dem Demonstrator ist zum heutigen Stand die Modellierung und Simulation auf Basis von ERP-Daten in der dynamischen Prozesssimulation möglich. Grundlage ist das generische Referenzmodell. Der Mehrwert liegt insbesondere auf der Möglichkeit zur horizontalen und vertikalen Erweiterung und Substitution der Quellsysteme und Planungstools. Daten aus realen Produktionssystemen können in near-real-time über die betrieblichen Informationssysteme in die Modelle verschiedener Planungstools übertragen und durch die Simulation bewertet werden.

Im nächsten Schritt des Forschungsprojektes ist die Validierung des Demonstrators durch reale Massendaten angestrebt. Dies beinhaltet auch die Implementierung in einem Web-Tool und den Einsatz im industriellen Kontext. Im industriellen Einsatz gibt der Demonstrator simulationsfremden Experten die Möglichkeit, reale Systeme durch die Simulation zu verstehen und aktiv zu verbessern. Ziele sind beispielsweise die Minimierung von Durchlaufzeiten und Beständen sowie die Verbesserung des EPEI zur Erhöhung der Flexibilität. Vision ist die Integration zahlreicher Werkzeuge entlang des Planungsprozesses und das Ermöglichen von einer „Optimierung auf Knopfdruck“.

VIRTFac wird als Exzellenzprojekt durch die Wissenschaftsoffensive und INTERREG Oberrhein gefördert.

Schlüsselwörter:

Fabrikplanung, Digitaler Zwilling, Referenzmodell, Discrete-Event-Simulation, Industrie 4.0Literatur:

[1] Gartner, Inc.: Gartner Top 10 Strategic Technology Trends for 2019. Gartner. URL: www.gartner.com/smarterwithgartner/gartner-top-10-strategic-technology-t..., Abrufdatum 13.10.2020.

[2] Volkswagen: Volkswagen and Amazon Web Services to develop Industrial Cloud. URL: www.volkswagenag.com/en/news/2019/03/volkswagen-and-amazon-web-services-..., Abrufdatum 18.01.2021.

[3] Kritzinger, W.; Karner, M.; Traar, G.; Henjes, J.; Sihn, W.: Digital Twin in manufacturing: A categorical literature review and classification. In: IFAC-PapersOnLine 51 (2018) 11, S. 1016-1022. doi: 10.1016/j.ifacol.2018.08.474.

[4] Skoogh, A.; Perera, T.; Johansson, B.: Input data management in simulation – Industrial practices and future trends. In: Simulation Modelling Practice and Theory 29 (2012), S. 181-192. doi: 10.1016/j.simpat.2012.07.009.

[5] Reinhardt, H.; Weber, M.; Putz, M.: A Survey on Automatic Model Generation for Material Flow Simulation in Discrete Manufacturing. In: Procedia CIRP 81 (2019), S. 121-126. doi: 10.1016/j.procir.2019.03.022.

[6] Vieira, A.; Dias, L.; Santos, M.; Pereira, G.; Oliveira, J.: Setting an Industry 4.0 Research and Development Agenda for Simulation – a Literature Review. In: International Journal of Simulation Modelling 17 (2018), S. 377-390. doi: 10.2507/IJSIMM17(3)429.

[7] Straßburger, S.; Bergmann, S.; Müller-Sommer, H.: Modellgenerierung im Kontext der Digitalen Fabrik - Stand der Technik und Herausforderungen. Karlsruhe 2010.

[8] Drath, R.: Datenaustausch in der Anlagenplanung mit AutomationML: Integration von CAEX, PLCopen XML und COLLADA. Heidelberg New York 2010.